Wage bargaining and price negotiations

There is a slightly different German version of this article here.

Bargaining and trading about wages and prices for personal services is not easy. It may be the price tag for your own work, for yourself. On the other side high wages killed a lot of enterprises or forced them to shrink. Low wages combined with high productivity mean advantages in a competitive market.

An employer will hire a worker if the net worth of his work bigger than the his wage. Low wages and high productivity means more yield for the employer, more bonus and next career level. The employee or the seller of services wants to make more money. They know that overpay means being to expensive and getting laid off first.

What to do in this situation? Let me explain two different approaches:

Using Market Research, Game Theory and Scenarios

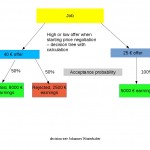

Let me give an example for a freelance teacher who bargains with a school. This private vocational school, Schulungs-Center Montgomery, does not pay equally. Most of the teachers are freelancers. Their price is 20 to 45 € per teaching hour. The teaching hour is 45 minutes. The teachers are forced by contract to keep their wages as a secret.

Sandra needs money and wants to teach Her Master of Business Administration is freshly examined.

She tries to get most of the situation. She looks at the website of the Schulungs-Center and notices the student’s tuition. 420 Euro per month. She thinks: 5000 € per year, 12 students in a class, 1000 teaching hours per year. That makes 60 € per teaching hour. 50% for general purposes and 50% for the teacher – that would be 30 EUR per hour for the teacher. For a new employee it is difficult to calculate how much money the employer will earn. Some market research helps.

May be, because of female, young professional the Schulungscenter will pay more? When looking at the staff she sees a lot of elder, retired people who will work for less than 25 Euro per hour.

She has two alternatives: either starting with 40 Euros per hour, with the risk that being young and well-educated is not sufficient to get more money, or going to the safe side with 25 € per hour. .

The Calculations

Say, the teaching duty is about 200 hours. If Sandra does not get the job, she has to clean rooms for 10 €/hour. We assume the probability to get the job is 50% when offering her teaching services for 40 € per hour, and 100% when offering for 25 € per hour, like in the chart. So she will get 5000 € when demanding 25€ per hour and (40 €/hour*200 hours * 50%)+ (10 €/hour * 200 hours *50%)= 5000 € when demanding 40 € per hour.

In this model, which is very close to reality, it does not matter if the teacher demands 25 € or 40 € per hour. The earnings for him are the same.

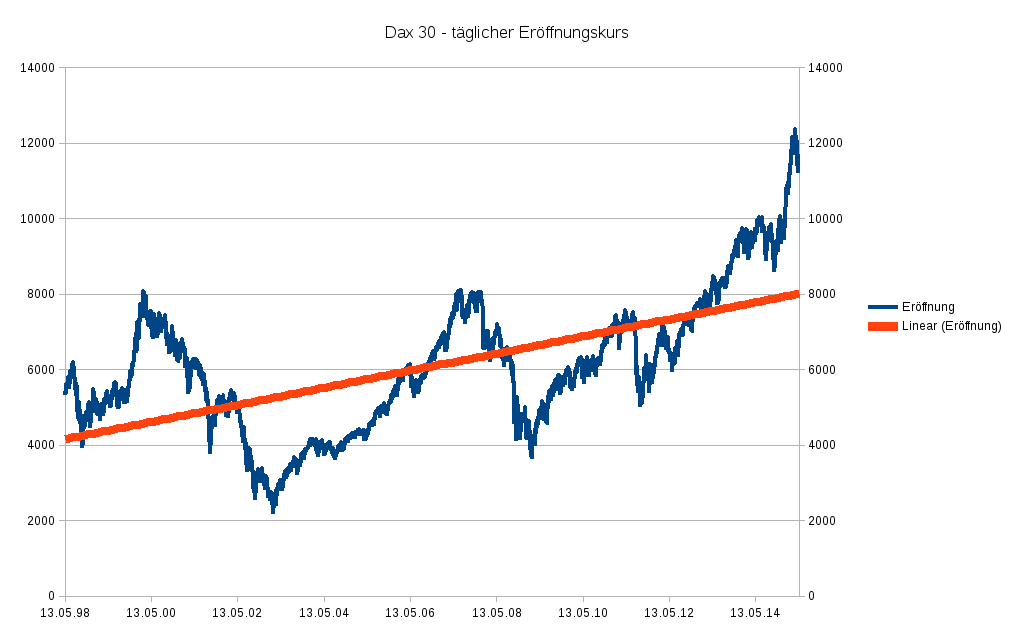

So what to do? Sandra should look at the whole picture of the economy to decide if the price for teaching rises or falls. In Freiburg where was a decline in the demand for freelance teachers in the last years. Classes shrunk, fewer students, less money.

Self-Esteem and better prices

Roman Kmenta has a very simple theory: High self-esteem, high income. Following his writings, Sandra should demand 40 € per hour and not falter. With high prices she tells everybody that her services are valuable. This will impress her contractors and they will accept her offers.

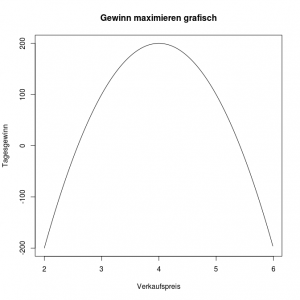

Cournot-Punkt

Cournot-Punkt